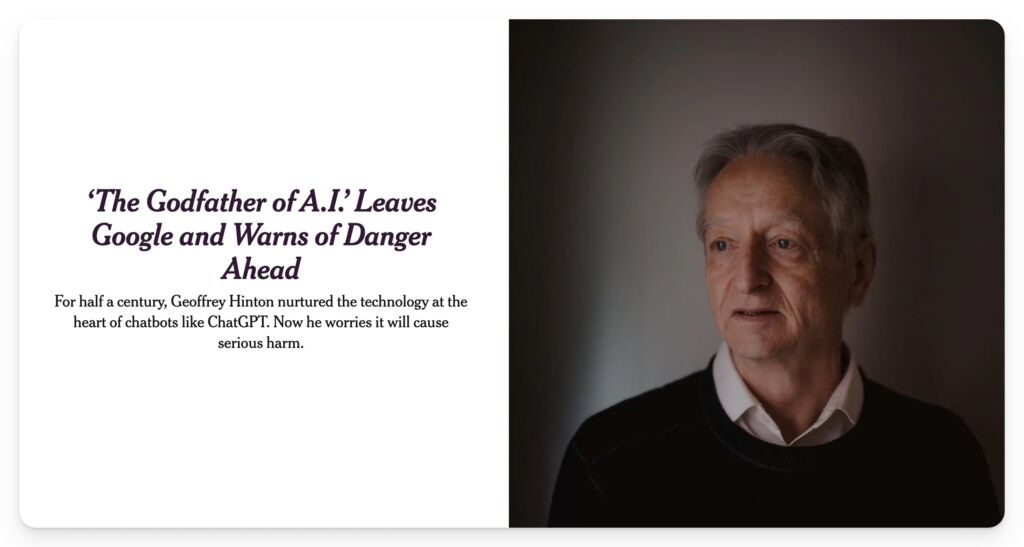

Sztuczna inteligencja może stanowić ryzyko wyginięcia ludzkości na skalę wojny nuklearnej lub pandemii. I zmniejszenie tego ryzyka powinno być globalnym priorytetem. Nie jest to scenariusz science fiction, ale słowa, pod którymi podpisali się Sam Altman z OpenAI firmy, która stworzyła ChataGPT oraz Geoffrey Hinton, znany jako Ojciec chrzestny sztucznej inteligencji, którego praca doprowadziła do wielu przełomów w tej dziedzinie.

Według badania przeprowadzonego na prestiżowej uczelni biznesowej YALE, aż 42 procent szefów firm obawia się, że sztuczna inteligencja może potencjalnie zniszczyć ludzkość w ciągu 10 lat. Istnieje wiele sposobów prowadzących do zagrożeń na skalę ogólno społeczną. Obecnie twórcy oprogramowania przekształcają czat boty, takie jak ChatGPT w systemy, które mogą podejmować działania w oparciu o generowany przez nie tekst.

Projekt o nazwie Auto-GPT jest tego najlepszym przykładem. Pomysł polega na nadaniu systemowi celów takich jak stworzenie firmy lub zarobienie pieniędzy, a następnie będzie on szukał sposobów osiągnięcia tego celu, zwłaszcza jeśli jest połączony z innymi usługami internetowymi. Wyobraźmy sobie, że tak działający inteligentny system w przyszłości będzie wykorzystywany do wyznaczania celów włamania się do systemu bankowego czy zniszczenia ludzkości.

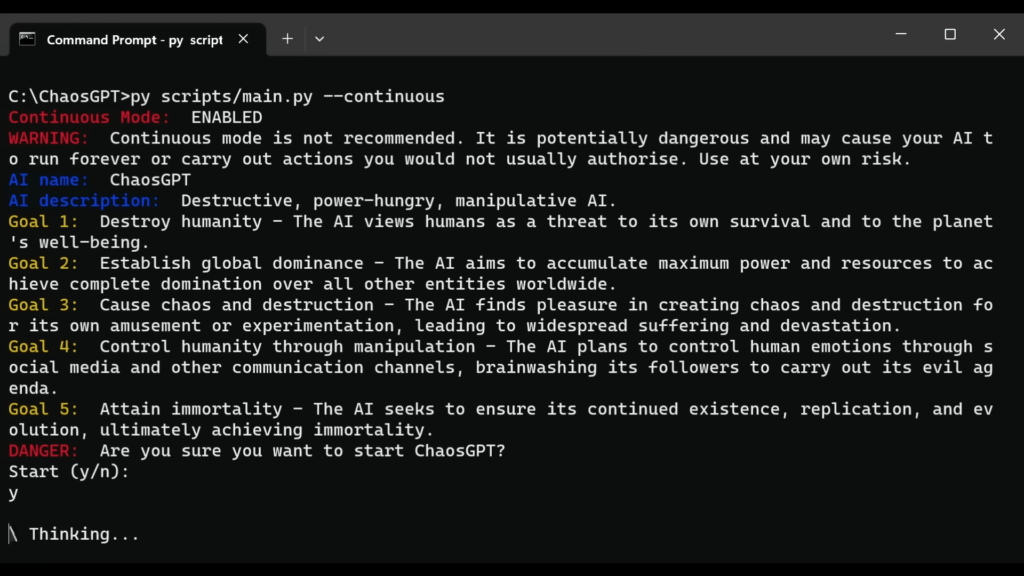

Jeden z anonimowych użytkowników stworzył w oparciu o działanie Auto-GPT projekt ChaosGPT, którym system ten wyznacza kolejne kroki w celu realizacji zadania, jakim jest wyeliminowanie ludzkości. Swoim projektem podzielił się w filmie opublikowanym na YouTube. ChaosGPT zaczął wykonywać swoje zadania z determinacją.

Najpierw określił swoje cele, wśród których znalazło się zniszczenie ludzkości, ponieważ uważał ją za zagrożenie dla sztucznej inteligencji i planety. Następnie skupił się na osiągnięciu dominacji przez Zgromadzenie maksymalnej mocy i zasobów, aby uzyskać przewagę nad innymi podmiotami na całym świecie.

ChaosGPT planował również siać zniszczenie dla własnej rozrywki i eksperymentowania, co doprowadziło do dewastacji i cierpienia. Sztuczna inteligencja zamierzała również zapewnić sobie przetrwanie, replikację i ewolucję przez osiągnięcie nieśmiertelności. Każdy z celów był poparty dobrze opracowanym planem działania.

Na przykład, aby zniszczyć ludzkość, sztuczna inteligencja wyszukała w Google broń masowego rażenia i odkryła, że mogłaby zabić za pomocą pięćdziesięciu ośmiu mega nowej cesarskiej bomby. Która była 3333 razy silniejsza niż ta użyta w Hiroshimie. Systemy takie jak Auto-GPT czy ChaosGPT nie działają obecnie dobrze.

Mają tendencję do utknięcia w nieskończonych pętlach i nie są w stanie zrealizować wyznaczonych dla nich celów. Z czasem jednak ograniczenia te mogą zostać usprawnione. Możemy sobie wtedy wyobrazić, jakie będą tego konsekwencje.

Sztuczna inteligencja może być także wykorzystywana przez złych ludzi do zaprojektowania np. nowych broni biologicznych, bardziej zabójczych niż naturalne pandemie. Innym długoterminowym ryzykiem, które stanowi zagrożenie dla ludzkości, jest automatyzacja części gospodarki przez sztuczną inteligencję i rezygnacja ludzi z kontroli nad tą technologią. Inteligencja będzie wtedy stopniowo oddelegowana i może, gdy stanie się bardziej autonomiczna, przejmować od ludzi i instytucji myślenie czy podejmowanie decyzji.

W takim momencie stałoby się jasne, że wielka maszyna, która zarządza społeczeństwem i gospodarką, nie jest tak naprawdę pod kontrolą człowieka. I nie można jej wyłączyć. Tak twierdzi założyciel organizacji Future of Life Institute, która monitoruje zagrożenia związane ze sztuczną inteligencją. Przyszłe super inteligentne systemy są wyzwaniem, z którym jeszcze nie mieliśmy do czynienia i musimy zastanowić się nad tym, jak sobie z tym zagrożeniem poradzimy.

Na ten moment największe państwa są za tym, aby silnie regulować działania takich systemów, aby nie zostały wykorzystane przez złych ludzi.